Seiten und Domains aus dem Google Index entfernen

Normalerweise sieht das Verhältnis zwischen Google und einem SEO aus wie in einem Video über Simon´s Cat:

Kurz zusammengefasst: Wir wollen rein in den Index. Doch was ist eigentlich, wenn wir raus wollen? Dafür gibt es mehrere Szenarien. Die Häufigste ist: Die Entwickler haben gepennt. Oder wir werden von einer einstweiligen Verfügung dazu gezwungen bestimmte Seiten verschwinden zu lassen. Hier gibt es die absonderlichsten Erlebnisse. Einmal habe ich jemandem dabei geholfen, rund 100 Seiten aus dem Google Index zu entfernen, weil es wegen der Beere, die er verkaufte, einen Patentstreit gab. Das Gericht war der Ansicht es reiche nicht, dass die Beere von seiner Seite verschwunden war, sie müsse auch aus den Google Ergebnissen verschwinden.

Dummerweise ist genau das nicht ganz so einfach. Dies gilt insbesondere dann, wenn Fristen einzuhalten sind. Es gibt unterschiedliche Ansatzpunkte, um Inhalte aus dem Google Index zu entfernen. Die Qual der Wahl hängt wie so häufig von der zur Verfügung stehenden Zeit ab. Als ergänzendes Kriterium stellt sich die Frage: Sollen Inhalte ausgeschlossen werden, die weiterhin online zugänglich sind oder handelt es sich um Inhalte, die bereits gelöscht sind? Einen Spezialfall bilden Inhalte, die aus dem Index verschwinden sollen, weil sie umgezogen sind.

Bei Inhalten, die ohne Indexierung durch Suchmaschinen online verfügbar sein sollen, gibt es drei Optionen:

- Schutz der Inhalte durch Authtentifizierungsmechanismen;

- Unterbinden des Crawlings durch Anpassung der Meta-Tags;

- Unterbinden des Crawlings durch Anpassung der robots.txt.

Unterbinden des Crawlings durch Authentifizierung

Geschützte Inhalte verschwinden früher oder später aus dem Google Index. Ich persönlich halte nicht viel von dieser Methode. Jedenfalls nicht, wenn es um den Ausschluss von Suchmaschinen-Crawlern geht. Im Grunde ist die Sache einfach: Nicht-öffentliche Inhalte stellt man nicht ungeschützt ins Netz. Hat man das versehentlich doch getan: Passwortschutz aktivieren! Am einfachsten geht dies mittels .htaccess und .htpasswd.

Anpassung der robots.txt

Die Möglichkeiten der robots.txt sind recht umfangreich. Im Wesentlichen werden die Ressourcen, die aus dem Index verschwinden sollen, dort vermerkt. Und zwar in der Form:

User-agent: *

Disallow: /beispiel-verzeichnis/

Das obere Beispiel gilt für alle Crawler in Bezug auf /beispiel-verzeichnis/ und alle Unterseiten. Was man sonst noch mit der robots.txt machen kann, haben die SEO-Trainees vor längerer Zeit sehr ausführlich dargelegt.

Anpassung der Meta-Tags

Mit dem Meta-Tag „robots“ lassen sich die Crawler auch dazu bewegen, bestimmte Inhalte nicht in den Index aufzunehmen. Dazu muss einfach folgende Angabe in den Header-Bereich der betroffenen Seite eingefügt werden:

<meta name=“robots“ content=“noindex, nofollow, noarchive“ />

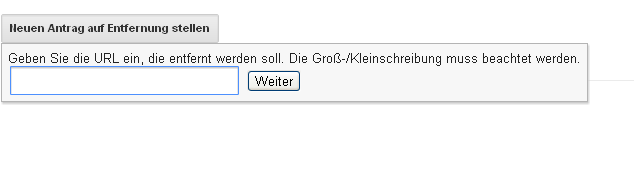

Entfernen der Inhalte durch die Google Webmaster Tools

Google selbst bietet Webseitenbetreibern die Möglichkeit, einzelne Seiten oder komplette Domains aus den Suchergebnissen zu entfernen. Dies ist in der Regel die schnellste Möglichkeit Inhalte aus dem Index zu verbannen, allerdings sollte sie immer in Kombination mit der Anpassung der robots.txt verwendet werden. Ist die betreffende Domain in den Google Webmaster Tools eingetragen und authentifiziert, lassen sich im Menüpunkt „Optimierung“ Anträge auf Entfernung einreichen. Das sieht dann so aus:

Bleibt das Eingabefeld leer, wird die ganze Domain aus dem Index entfernt. Sofern die Seite weiterhin von außen zugänglich ist, bleibt die Löschung nur dauerhaft aktiv, wenn die robots.txt entsprechend angepasst wurde.

Es gibt noch eine weitere Stelle, wo man den Google-Crawler aussperren kann. Und zwar im HTTP-Header mit dem „X-Robots“-Tag:

https://developers.google.com/webmasters/control-crawl-index/docs/robots_meta_tag

Besonders praktisch für PDFs und ähnliches, wenn man der robots.txt nicht ganz traut.

Gruß,

Michael